AI is being embedded in SaaS applications, autonomous agents take actions in real time, and low- or no-code tools let teams build their own AI automations across the enterprise. But while adoption and innovation accelerate, security is still catching up. AI systems behave in ways that traditional defenses were never designed to monitor, and security leaders are increasingly expressing concern:

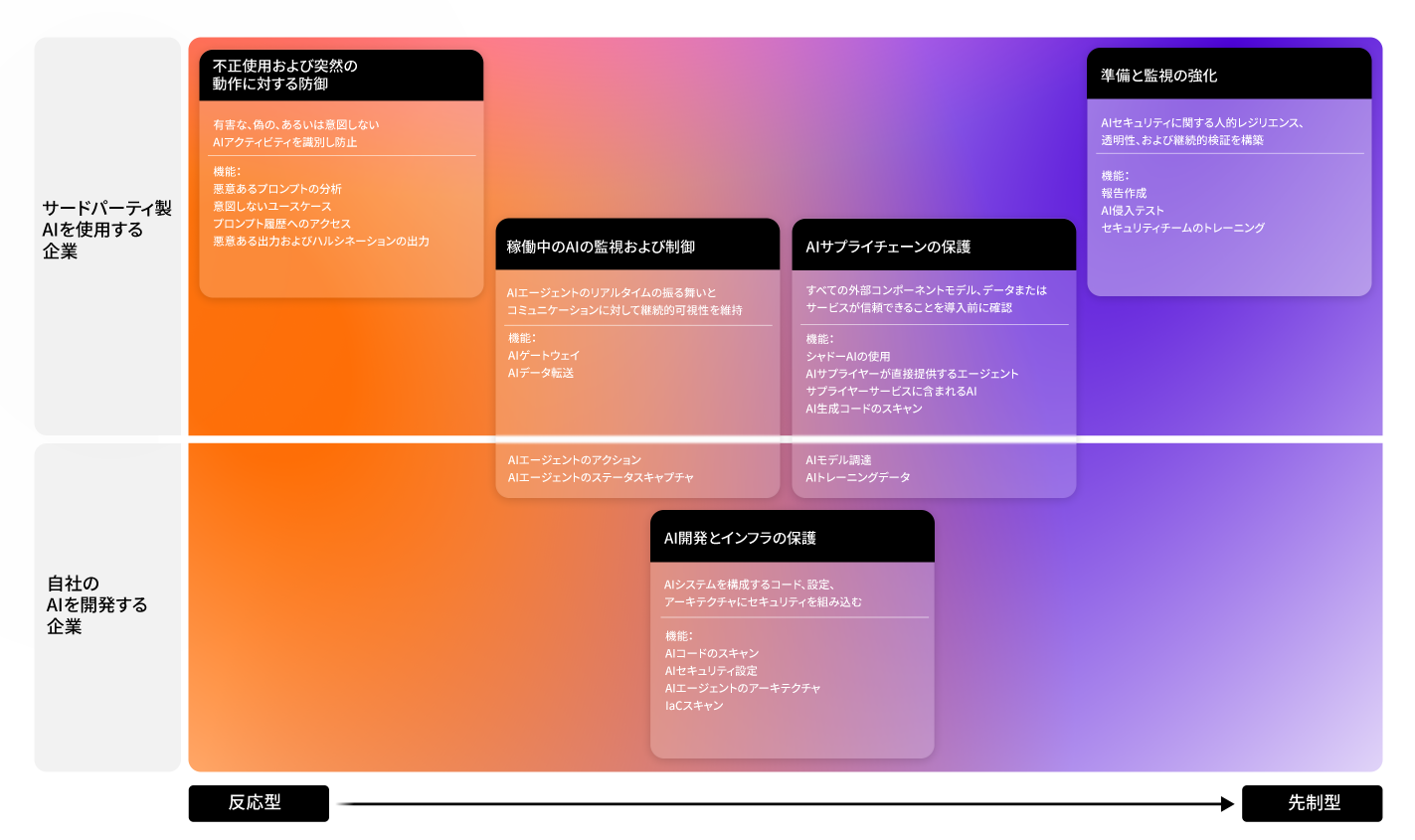

企業内のAIを防御

AI is accelerating faster than governance can keep up, expanding attack surfaces and creating unseen risks. From data and models to AI agents and integrations, security starts by knowing what to protect.

Security professionals are increasingly concerned about the rise of AI

44%

are extremely or very concerned with the security implications of third-party LLMs (like Copilot or ChatGPT)

92%

are concerned about the use of AI agents across the workforce and their impact on security

How concerned are you about the security implications of the following AI technologies in your organization’s computing environment?

Number of respondents extremely or very concerned about the security impact of different kinds of AI use

Number of respondents extremely or very concerned about the security impact of different kinds of AI use

Number of respondents extremely or very concerned about the security impact of different kinds of AI use

Number of respondents extremely or very concerned about the security impact of different kinds of AI use

Number of respondents extremely or very concerned about the security impact of different kinds of AI use

AIの導入はアタック

サーフェスを急激に拡大

自律型および生成AIエージェント

単独でアクションを実行できるシステムは人間のガードレールや監視を超えて動作します。

SaaSおよび生産性ツールに埋め込まれたAI

従業員はAI機能を使って機密性の高いデータをセキュリティツールから直接見えないところで処理する可能性があります。

クラウドおよびオンプレミスプロバイダーがAIを使ってサービスを拡張

新しい組み込み機能により複雑性が高まりコントロールの境界が拡張されます。

ベンダーや市販のソフトウェアがAI機能を追加

サードパーティ製ツールは、明確な監視機能あるいはリスク評価なしにAI機能を追加することがあります。

Engage today, safeguard tomorrow

AI is moving fast. Staying informed isn't just a competitor advantage – it's a business imperitive. Access expert-led programs and practical resources built to strengthen your AI security strategy.

Enter the readiness program

Get exclusive access to product updates, thought leadership, and opportunities to connect with peers

Speak to us

Speak with a Darktrace expert to get tailored, practical guidance to secure your AI

Watch our launch broadcast

Catch up on our launch of new Secure AI innovations and discover how you can deploy AI agents with confidence

See our product page

See our survey findings for how security leaders are thinking about security AI and discover our framework

セキュリティリーダーは組織内のどこでAIが使われているかを知る必要があります

AIは従業員の生産性ツール、クラウドサービス、ベンダー製ソリューション、社内開発システムなど、さまざまなところに使われています。AIがどこで、どのように使われているかについて明確に把握していなければ、最も強固なセキュリティ戦略も弱体化してしまうようなブラインドスポットが組織内に生じます。

正式に承認されているもの、承認されていないものを含め、従業員がどこでAIを使用しているかをマッピングします。さまざまな部門での禁止されているツールおよびシャドーAIの利用を調べる必要があります。

クラウドプロバイダー、オンプレミスシステム、ベンダー製ソリューションにAI機能が埋め込まれていないか調べます。どのサプライヤーがAIを使用しているか、組織のデータをどのように使用しているかを理解することは、可視性を維持し契約上の保証を得る上できわめて重要です。

開発チームと協力して内部のモデルがどのように作成および管理されているかを整理し、強力なガバナンスに必要となる可視性を確保します。

Understand what it really means to secure AI in the enterprise

Discover how to identify AI-driven risks, so you can establish AI governance frameworks and controls that secure innovation without exposing the enterprise to new attack surfaces.

AI駆動サイバーセキュリティへの理解を深める

AIは組織の防御、検知、ガバナンスのあり方を変えつつあります。以下のリソースでは、AIツールの評価から責任あるガバナンス、そして組織の成熟度と準備度の理解にいたるまで、エキスパートのさまざまな考察をご提供しています。実用的なフレームワークの説明と今後を見通した研究結果をお読みになり、ビジネスのイノベーションを安全に進める上でお役立てください。

透明性と責任あるイノベーションを通じて信頼を構築

イノベーションとガバナンス、セキュリティのバランスをどうとるべきか?サイバーセキュリティにおける倫理的かつ説明可能なAIを導く原則についてご確認ください。

サイバーセキュリティで使用される多様なAIのタイプを知る

教師付き機械学習からNLPまで、現代のレジリエンスを実現する様々なツールと、それらを組み合わせて新手の脅威を阻止する手法についてご確認ください。

自社のAI導入の現状をベンチマーク

AI成熟度モデルはCISOとセキュリティチームが現在の機能を評価し、自律的で回復力のあるセキュリティオペレーションに向けたロードマップを作成するのに役立ちます。

情報に基づいたAIセキュリティツールへの投資判断

We surveyed 1500 cybersecurity pros around the world to uncover trends on AI threats, agents and security tools.

Become an expert in securing AI – join the Readiness Program

AI is moving faster than your security. We’re about to change that.

The Securing AI Readiness Program by Darktrace is designed to bring together a cohort of IT and security leaders who are confronted with the common experience of securing AI tools at their organizations.

The information you’ll receive in this program has been designed to help security and IT professionals anticipate, understand, and prepare for the risks and realities of AI adoption, from security and governance to operational and reputational impact so they can clearly advise the business, set guardrails for responsible AI use, and guide adoption with confidence at a time when uncertainty is the norm.

Register your interest today

Thank you for registering, and congratulations on your first step to becoming an expert in securing AI in the enterprise. We'll be in touch soon giving you early access to product updates, exclusive thought leadership content, and community experiences with leaders navigating similar challenges.

FAQ

AIによるセキュリティリスクを見つけ出すには、AIシステムがデータ、ユーザー、接続されたテクノロジーとどのように相互動作するかを理解する必要があります。AIのモデル、プロンプト、インテグレーションに対して継続的に監視を行うことで異常や意図しない動作を発見することができます。AIセキュリティポスチャ管理と組み合わせることにより、AI環境の進化に応じたシステムの完全性について明確な理解が可能になります。

AIガバナンスおよびAIリスク管理フレームワークは、AIがどのように管理および監査され、組織と法規制の求める基準に対応するかを定義するものです。NIST AI RMF(Risk Management Framework)やISO/IEC 42001等の規格は、透明性、説明責任、一貫性を強調しており、AIシステムがライフサイクル全体に渡り責任を持って管理されるようにするものです。

責任あるAIとは、確立されたガバナンスおよび法規制の原則に従った、安全かつ倫理的なAIの使用を意味します。サイバーセキュリティにおいては、AIによる判断とアクションが理解可能、検証可能であり、企業システム内に安全に統合できるようにするための、透明性、追跡可能性、信頼性の確保に重点が置かれています。

AIの監視においては、モデルの動作、データフロー、システム出力に対する継続的な観察を行い、予期しないあるいは承認されないアクティビティを識別する必要があります。AIが環境内でどのように動作しているかを継続的に可視化することで、正確性、安全性、コンプライアンスに対する自信を維持することができます。

AIセキュリティポスチャ管理(AI-SPM)とは、AIシステムの設定、ポリシー、管理環境を維持し評価するプロセスです。セキュリティ準備度に対する継続的な考察を提供し、設定ミスやリスクの発生がオペレーション全体に影響する前にセキュリティチームがそれらを検知できるようにします。

AIサプライチェーンセキュリティは組織に導入される外部AIコンポーネント、たとえばモデル、データセット、API等の完全性を検証することに重点を置きます。外部ソースが正規のものであり、適切にライセンスされ、悪意あるあるいは改ざんされたコンテンツが含まれていないことを検証するのに役立ちます。

AIシステムの保護とは、モデルの作成、トレーニング、開発、継続的オペレーションを含むAIライフサイクル全体にわたってリスクに対処することを意味します。これには、データの保護、システム動作の監視、および信頼と安定性を維持するためのガバナンス構造の管理が含まれます。

AIモデルのリスクとは、データ品質の不良、設計の欠陥、または操作により、モデルがバイアスのかかった、不正確な、または有害な出力を生成する可能性のことです。AIモデルリスクを軽減するには、トレーニングデータの信頼性、パフォーマンス指標の正確性、モデル動作の透明性が重要となります。